고온 고분자 연료전지를 이용한 데이터 센터용 CCHP 시스템의 에너지 절감 효과

2023 The Korean Hydrogen and New Energy Society. All rights reserved.

Abstract

Data centers not only consume significant electricity to operate IT equipment, but also use a lot of electricity to cool the heat generated by IT equipment. The waste heat of a high-temperature polymer electrolyte fuel cell (HT-PEFC) is capable of producing cooling , so it can be effectively applied to data centers that require cooling throughout the year. The energy-saving effects of the proposed combined cooling, heat and power (CCHP) system using HT-PEFC. That was analyzed based on the annual energy consumption data of a specific data center. When the system was running at 100% of the year, It was shown that the installation of 1 MW of the proposed system can save 3,407 MWh of electrical energy per year. In addition, compared to the existing system, the annual power usage effectiveness can be improved from 2.0 to 1.57 and 6,293 MWh of extra heat energy per year can be produced to sell. Furthermore, sensitivity analysis was performed on the fuel cell operating temperature and current density to guide the appropriate installation capacity of the proposed system.

Keywords:

High temperature polymer electrolyte fuel cell, Simulation, Data center, Combined cooling, heat and power system, Free cooling키워드:

고온 고분자 전해질 연료전지, 시뮬레이션, 데이터 센터, 삼중 열병합 시스템, 프리 쿨링1. 서 론

온실가스로 인한 지구 온난화가 가속화됨에 따라 국내에서는 최근 온실가스 감축 목표를 상향하며 탄소 중립 달성을 위한 노력을 이어가고 있다1). 2050년 탄소 중립 실현에 있어 우려되는 부분은 ICT 산업에서 발생되는 탄소 배출량으로, 2040년까지 연평균 7.3%씩 성장하여 2016년 글로벌 탄소 배출량의 14%에 이를 것으로 보고된 바 있다2). 이러한 성장의 배경은 데이터 센터 산업의 엄청난 전력 소비와 관련이 있다. 디지털 서비스를 이용하려면 개별 사용자뿐만 아니라 서비스를 제공하는 서버 역시 전력을 소비한다. 데이터 센터 내의 서버는 24시간 지속적으로 운전되므로 상당한 양의 전력을 소비하게 된다. 데이터 센터의 전력 사용량 증가는 CO2 배출량 증가로 이어진다3,4).

데이터 센터는 총 에너지의 약 40%를 IT 장비 냉각에 사용하며, 요구되는 냉각은 전기를 소비하여 이루어진다5). 따라서 데이터 센터를 냉각하는 효과적인 방법을 찾으면 데이터 센터의 탄소 배출량을 줄일 수 있다. 겨울철에도 냉방 수요가 있는 데이터 센터의 특성에 따라 냉각탑을 이용한 외기냉수냉방 시스템(free cooling system)을 적용하여 냉방에 소비되는 에너지를 줄이려는 연구가 지속적으로 보고되고 있다6-9). 하지만 외부 기온에 의존적인 외기 이용 냉방 시스템을 도입하는 것만으로는 데이터 센터의 모든 냉방 수요를 충족하기 어렵기 때문에 결국 기존의 전기 냉동기를 함께 가동해야 한다. 고온 고분자 연료전지는 친환경 발전 장비로 순수 수소를 이용하여 발전하면 탄소를 전혀 배출하지 않고, 발전하는 동안 발생되는 높은 온도의 폐열을 활용하여 냉열을 제공할 수도 있다10-13). 외기냉수냉방과 고온 고분자 연료전지 시스템을 같이 사용하면 그리드 전기를 사용하지 않고 데이터 센터의 사계절 냉방을 해결할 수 있으므로 에너지 절감에 효과적이며, 탄소 배출량도 저감할 수 있다. High-temperature polymer electrolyte fuel cell (HT-PEFC)과 이중 효용 흡수식 냉동기를 결합한 combined cooling and power (CCP) 시스템은 데이터 센터에서 요구되는 전기와 냉열을 모두 제공 가능하여 높은 효율을 갖는다13). 하지만 외기냉수냉방 시스템과 같이 사용하게 되면 실제 냉방 부하가 적은 겨울철에 가동률이 현저히 떨어지게 된다. 본 연구에서는 외기냉수냉방 시스템을 도입하고 상대적으로 냉방 부하가 적은 계절에는 온열을 판매하여 가동률을 높일 수 있는 combined cooling, heat and power (CCHP) 시스템을 제안하고자 한다. CCHP 시스템은 연료전지, 흡수식 냉동기 그리고 외기냉수냉방 시스템으로 구성되어 모델링되고 시뮬레이션되었다. 본 연구에서는 데이터 센터에 CCHP 시스템을 도입했을 경우의 에너지 절감 효과와 탄소 배출량 저감 효과를 분석하기 위해 기존의 한전에서 공급하는 전기를 이용하는 터보식 전기 냉동 시스템과 제안 시스템의 소비 전력량을 비교하였다. 또한 연료전지 운전 조건을 변화시키면서 데이터 센터의 전력효율지수(power usage effectiveness, PUE)를 평가하였다.

2. 모델링 & 시뮬레이션

2.1 CCHP 시스템 구성

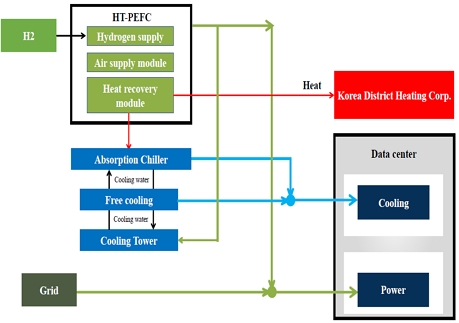

본 연구에서 제안하는 CCHP 시스템은 HT-PEFC와 흡수식 냉동기, 그리고 냉각탑과 프리 쿨링용 열 교환기가 있는 외기냉수냉방 시스템으로 구성된다. Fig. 1은 CCHP 시스템의 데이터 센터 전력 공급 방법을 보여준다. 데이터 센터에서 요구되는 전력은 HT-PEFC로 발전된 전기와 외부 그리드로부터 공급된다. 냉방 부하는 CCHP 시스템에서 만드는 냉열로 충족시키고 부족한 냉방 부하는 기존의 터보식 냉동기로 공급받게 된다. 냉방 부하를 초과하고 남는 연료전지로부터 발생한 폐열은 지역난방공사에 난방열로 판매된다.

2.2 데이터 센터 연간 부하 모델링

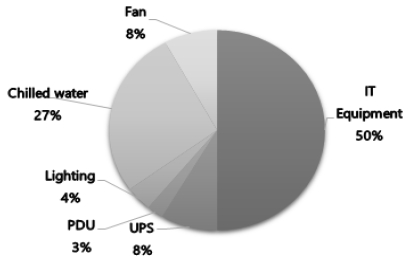

시뮬레이션 대상의 전기 및 냉방 부하를 추정하기 위해서 국내 데이터 센터의 실제 시간별 총 전기 부하를 근거로 각 구성 요소마다 시간에 해당되는 개별 전기 부하를 계산하였다. 기존 데이터 센터의 IT장비 및 각 구성 요소의 전력 소비가 Fig. 2와 같다고 가정하면14) 각 구성 성분에서 발생하는 부하는 다음과 같이 계산된다.

| (1) |

| (2) |

| (3) |

| (4) |

| (5) |

| (6) |

여기서 Pel,tot는 데이터 센터의 전체 소비전력, Pel,IT는 IT 장비 소비전력이고 Pel,etc는 전원 분배 장치(power distribution unit, PDU), 무정전 전원 장치(uninterruptible power supply, UPS) 그리고 조명 장비에 의해 소비되는 전력이다. Pel,chilled_wate는 냉수(chilled water) 공급에 사용되는 소비전력으로 냉각탑 소비전력(Pel,cooing tower = Pel,chilled_water × 15%)과 냉동기 소비전력(Pel,chiller)의 합이다.

IT 장비 및 조명에 의해 흡수된 모든 전력이 궁극적으로 열로 변환되고 UPS 및 변압기에 의한 전력 손실도 열로 변환된다고 가정하고 다음과 같이 냉방부하를 추정하였다15).

| (7) |

연간 에너지 소비량은 IT 가동 시간에 발생된 소비전력의 합으로 아래와 같다.

| (8) |

2.3 데이터 센터 냉각 방법

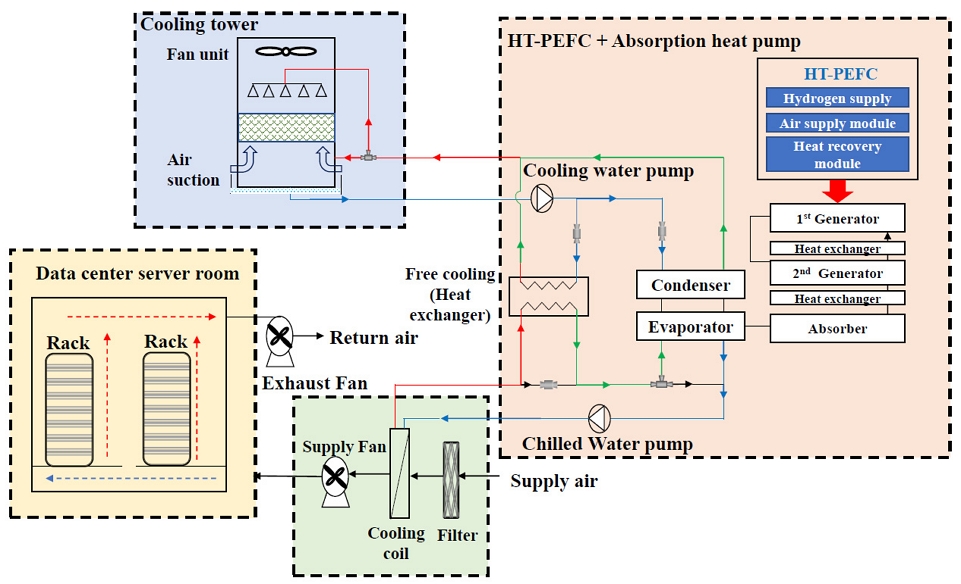

데이터 센터의 냉방은 기본적으로 차가운 외기와 냉각탑(cooling tower)을 이용한 프리 쿨링 기반 냉각 방식을 활용하였다. 외기 온도가 데이터 센터를 냉각하기에 부족할 경우 연료전지 폐열로 냉열을 만드는 흡수식 냉동기를 사용한다. 냉각은 외기 온도에 따라 3가지 모드로 운영된다. 외기 온도가 높은 여름철에는 흡수식 냉동기만 가동하고 봄, 가을에는 프리 쿨링과 흡수식 냉동기를 동시에 사용한다. 외기 온도가 낮은 겨울에는 냉각탑을 순환하는 냉각수와 대기를 접촉하여 냉각된 냉각수를 직접 이용한다. Fig. 3과 같이 CCHP 시스템에서 생성된 냉수는 전산실 공기 조화 유닛의 냉각 코일에서 뜨거운 공기와 열을 교환한 후, 차가워진 공기를 데이터 센터 내부로 공급하여 냉열을 제공하는데 사용된다.

2.4 시뮬레이션 분석 방법

모델링 기반의 1 MW CCHP 시스템을 대상으로 총 두 가지 종류의 시뮬레이션을 수행하였다. 첫 번째 시뮬레이션은 HT-PEFC 운전 조건을 항상 표준 조건(160℃, 0.2 A/cm2)에서 연중 100% 가동된다고 가정하고 진행되었다. 데이터 센터에서 CCHP 시스템 가동 시 발생되는 효과를 살펴보기 위해 전기 에너지 절감량, 추가 온열 생산량, 탄소 배출 저감량과 PUE 값을 분석하였다. PUE는 데이터 센터의 총 전력 사용량 중 서버 등 기타 IT 장비와 관련된 전력 비율을 나타내는 값으로 데이터 센터의 전력 효율성을 측정하는 지표 중 하나이다. PUE가 1.0이면 전력의 100%가 IT 장비에 사용되는 것을 의미하며, 냉각장치와 조명 등의 기타 소비전력의 증가는 PUE를 증가시킨다16). 시뮬레이션 결과로 계산된 전기 에너지 절감량은 기존 시스템에서 냉방에 사용되었던 전기를 CCHP의 냉열 공급으로 대체하여 절감된 전기 에너지를 의미한다. 데이터 센터에 필요한 냉열을 공급하고 남은 열 에너지는 주변 시설에서 이용 가능한 온열 에너지로 제공된다. CO2 배출량은 CCHP 도입 후 절감된 연간 전력 사용량에 Table 1의 전기 사용에 따른 이산화탄소 배출 계수를 곱하여 계산하였다.

두 번째 시뮬레이션은 HT-PEFC의 스택 온도 및 전류밀도를 바꿔가며 상기 효과의 변화를 관찰하는 민감도 분석을 실시하였다. 이와 같이 CCHP 시스템 운전 조건을 분석하면 적절한 시스템 설치 용량을 가이드할 수 있다. 운전 온도 150-180℃ 범위에서 시스템 설치 수에 따른 PUE 및 에너지 절감 효과를 분석하였다. 그 후 같은 방법으로 전류밀도 0.2-0.4 A/cm2 범위에서 시스템 설치 수에 따른 PUE 및 에너지 절감 효과도 분석하였다.

3. 결과 및 고찰

3.1 데이터 센터의 연간 에너지 수요

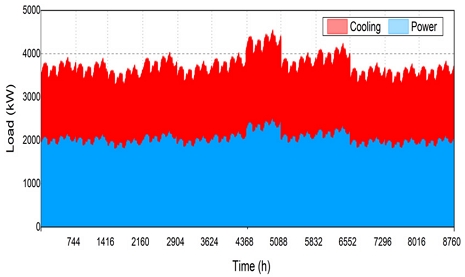

Fig. 4는 위에서 제안한 연간 데이터 센터 부하 모델링을 적용하여 얻은 값으로, 365일에 해당되는 8,760시간 동안의 대상 데이터 센터의 시간별 전기 부하와 냉방 부하를 누적으로 표시하여 적절히 구분하였다. 최대 전력 부하는 2,888 kW, 냉방 부하는 2,044 kW이며, 기존 시스템에서 1년간 소비되는 전기 에너지는 총 20,773 MWh이다. 이를 통해 데이터 센터 부하 모델링을 통해 제안한 CCHP 시스템이 대신할 수 있는 데이터 센터 냉방 부하를 정확히 추산할 수 있게 되었다.

3.2 프리 쿨링 시스템의 에너지 절약 효과

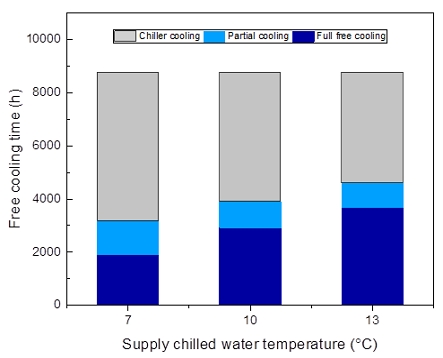

기존 냉열원 시스템(터보 냉동기 가동)을 기준으로 프리 쿨링 도입에 따른 에너지 절감 효과를 분석하였다. 연간 외기 온도는 국내 A 지역의 데이터를 반영하였다. 냉각탑 출구 온도와 외기 습구 온도 차이를 의미하는 쿨링 어프로치(cooling approach)는 4℃이며 완전 프리 쿨링(full free cooling) 모드에서는 냉각탑에서 제조한 저온 냉각수(cooling water)를 이용해 15℃로 환수된 냉수(chilled water)를 7℃로 냉각하여 데이터 센터 내에 공급한다. 냉각탑을 통해 설정한 온도의 냉수를 제조하기 어려운 봄, 가을에는 냉각수로 냉수를 1차 예냉(precooling)시킨 후, 추가로 냉동기를 통해 공급 온도인 7℃를 맞추도록 설정하는 부분 프리 쿨링(partial free cooling) 방식이 적용되었다. 이때 예냉된 냉수와 공급 냉수 온도차는 4℃이다. 데이터 센터의 실내 온습도 조건을 완화하면 냉동기는 냉수 출구 온도를 높게 유지할 수 있어 coefficient of performance (COP)가 크게 향상되어 냉방 에너지를 절감할 수 있다17). 냉수 설정 온도에 따른 데이터 센터 공급 냉수 설정 온도 변화가 프리 쿨링 시스템 운전에 미치는 영향을 확인하고자 냉수 설정 온도를 7℃에서 13℃까지 증가시키며 시뮬레이션하였고, 실질적으로 프리 쿨링의 효용성을 나타내는 지표로 프리 쿨링 가용 가능한 시간을 분석하였다. 프리 쿨링 시스템의 적용에 따른 설정 온도가 7℃, 10℃, 13℃면, 설정에 따라 각각 외기 습구 온도가 5℃, 8℃, 11℃ 이하일 때 프리 쿨링 시스템이 가동된다. Fig. 5에서 볼 수 있듯이 데이터 센터 공급 냉수의 설정 온도를 증가시키면 프리 쿨링 가동 가능한 외기 습구 온도 범위가 증가함에 따라 연간 프리 쿨링이 가능한 시간이 증가하는 것을 확인할 수 있다.

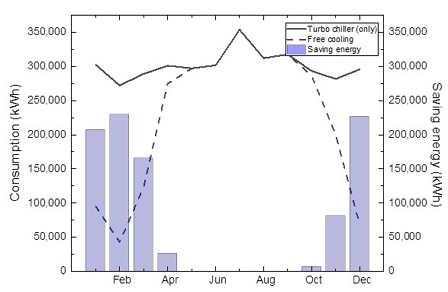

프리 쿨링 시스템의 에너지 절감 효과를 분석하고자 기존 데이터 센터의 냉방 시스템에 프리 쿨링 시스템 적용 유무에 따른 에너지 소비의 차이를 비교하였다. Table 2와 Fig. 6과 같이 기존 시스템의 냉방에 연간 3,618 MWh의 전기 에너지가 필요하지만 프리 쿨링 시스템을 적용하면 연간 2,674 MWh의 전기 에너지로 냉방이 가능하다. 즉 프리 쿨링 시스템 적용 시 최대 26%까지 전력 사용량이 절감되는 결과를 나타낸다. 하절기인 5-9월에는 프리 쿨링 효과가 거의 없어 CCHP 시스템의 흡수식 냉동기 운전이 필요하다. 반면 동절기인 12-2월에는 낮은 외기 온도로 완전 프리 쿨링 가동 시간이 증가하므로 전력 절감량이 많아진다. 간절기인 3-4월, 10-11월에는 부분 프리 쿨링 효과로 에너지 사용량이 절감되었다.

3.3 시스템의 에너지 절감 및 탄소 배출 저감 효과

기존 시스템 대비 CCHP 시스템 적용 시 에너지 절감 및 탄소 배출 저감 효과를 비교 분석하기 위해서 다음과 같이 운전 조건을 설정하였다. 시스템의 설치 용량은 1 MW으로 정격 연료전지 운전 온도는 160℃, 운전 전류밀도는 0.2 A/cm2, 공급 냉수 설정 온도는 7℃이다. 데이터 센터의 전기 부하는 연료전지 발전과 외부 그리드 전기에 의해 모두 충족되며 데이터 센터의 냉방 부하는 프리 쿨링과 CCHP 시스템의 흡수식 냉동기 그리고 기존의 전기 냉동기로 모두 충족된다. 시뮬레이션 결과를 토대로 총 전기 에너지 절감 효과를 분석한 결과 냉방 부하에 필요한 전기량인 연간 3,407 MWh의 전력 사용량이 절감되었다. 기존 시스템 대비 총 전기 소비량의 약 16.4%를 감소하는 효과를 볼 수 있으며 월별 전력 감소량은 Table 3과 같다. PUE 값은 기존 2.0에서 1.57까지 감소하였다. CCHP 시스템은 냉열 생산에 쓰고 남은 온열을 연간 6,293 MWh 추가적으로 생산하여 주변 시설에 공급할 수 있다. 프리 쿨링으로 인해 겨울철(11-2월)에는 추가 열 발생량이 크다. 탄소중립 기여도를 분석하기 위해서 CO2 배출량을 계산하였다. CO2 배출량은 시뮬레이션을 통해 산정된 연간 전력 사용량에 Table 3과 같이 탄소 배출 계수를 적용하여 계산하였다. 냉방에 소비된 에너지 절감에 따른 배출량 감소 효과로 기존 시스템 대비 연간 1,555톤의 CO2 배출이 저감되는 것으로 나타났다.

3.4 시스템의 운전 조건에 따른 민감도 분석 결과

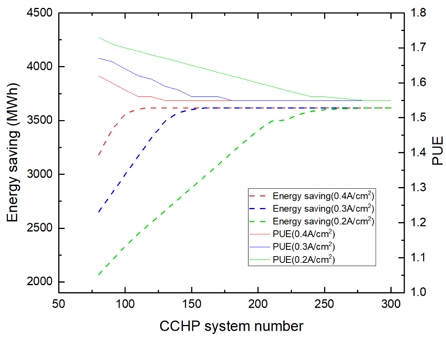

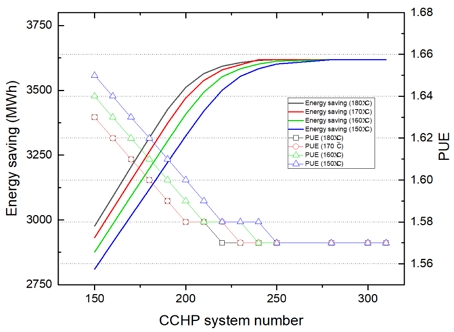

데이터 센터 에너지 절감 및 PUE 값에 영향을 미치는 다양한 요인을 선정하고 이들의 변화에 따라 분석 결과를 살펴봄으로써 산정된 값에 신뢰성을 부여하고자 하였다. CCHP 시스템으로 데이터 센터의 냉방 부하를 더 많이 부담할수록 기존의 전기 냉동기의 운전 부담이 줄어들어 전기 에너지의 절감량은 증가하게 된다. Fig. 7에서 운전 온도 변화에 따른 PUE와 전기 에너지 감축량 변화를 보면 CCHP 시스템 설치 수가 동일할 경우, 높은 운전 온도에서 에너지 절감 효과가 더 크다. 운전 온도를 약 10℃ 증가시킬 때 PUE는 약 0.01 정도 개선되었다. 이는 연료전지 온도 증가에 따른 흡수식 냉동기의 COP 향상으로 인해 냉방에 사용되는 전기 에너지 사용 부담이 줄어든 결과이다. 하지만 Fig. 7에서 모든 온도 조건에서 특정 시스템 수 이상이 되면 PUE는 동일한 값으로 수렴하게 되는 것을 확인할 수 있다. 이는 CCHP 시스템의 발전만으로 데이터 센터의 냉방 부하를 모두 충족하게 되어 더 이상 냉방에 소비되는 전기 에너지 절감 효과가 나타나지 않게 되기 때문에 PUE 값이 최소화된 결과이다. 각각의 온도 조건에 따라 PUE의 최젓값에 도달하는 시스템 수는 서로 다르지만 PUE의 최젓값은 모두 1.57로 같다. 그 이상의 시스템 수를 도입하면 잉여열이 증가하게 되는데 이는 지역난방공사에 판매 가능한 열로 사용된다. 따라서 운전 조건에서 PUE가 최젓값에 도달할 때의 시스템 수를 특정하면 냉방 부하에 소비되는 전기 에너지를 최대로 절감하기 위해 필요한 최소 시스템 수를 계산할 수 있다. 결과적으로 CCHP 시스템 도입으로 최대 연간 3,618 MWh의 전력량을 절감할 수 있고 이는 기존의 시스템 대비 약 17.4% 전력량이 감소되는 효과와 같다.

Annual electrical energy saving and PUE of data center based on CCHP system at different HT-PEFC operating temperature

Fig. 8은 동일 시스템 수를 운영할 때 운전 전류밀도 변화에 따른 에너지 절감과 PUE 변화를 나타낸다. 이는 운전 온도가 160℃로 같은 경우 운전 전류도 변화에 따른 효과를 분석한 결과로, 운전 전류밀도 증가 시 PUE가 약 0.02 개선되었다. 이는 운전 전류밀도가 높아질수록 흡수식 냉동기의 열원으로 사용할 수 있는 스택의 폐열량이 크게 증가하면서 데이터 센터에 공급 가능한 냉방 용량도 늘어나기 때문이다. 앞선 경우와 같이 일정 시스템 수에 도달하면 소비전력 감소량이 일정한 값으로 수렴하게 되는데 이는 마찬가지로 CCHP 시스템 발전으로 요구되는 냉방 부하를 모두 충족할 수 있는 시스템 수에 도달하게 된 것을 의미한다. 앞의 분석 결과와 같이 높은 온도와 전류밀도로 운전하면 높은 효율을 제공하기 때문에 초기 설치 수는 적게 필요하지만 높은 온도 및 부하에서의 운전은 장기적인 관점에서 열화와 같은 문제로 내구성에 취약할 수 있다는 점을 고려해야 한다.

4. 결 론

데이터 센터에 HT-PEFC 기반의 CCHP 시스템을 적용할 경우 얻을 수 있는 에너지 절감 및 탄소 배출 저감 효과를 분석하기 위해 모델 기반 시뮬레이션을 수행하였다. 먼저 실제 데이터 센터의 시간별 총 전기 부하를 기반으로 만든 연간 전기 및 냉방 부하 모델에 프리 쿨링 시스템을 적용한 후 에너지 절감 효과를 확인하였고, 그 다음 프리 쿨링을 포함한 CCHP 시스템으로 데이터 센터의 전기 및 냉열을 공급할 때 절감 가능한 에너지와 그에 의해 감소되는 탄소배출량을 확인하고자 두 가지로 시뮬레이션을 진행하였다. 1 MW (160℃, 0.2 A/cm2) 용량의 CCHP 시스템을 가동하였을 경우, 기존 시스템과 비교하여 냉방에 사용되는 에너지가 16.4% 감소하였다. 데이터 센터의 전력 사용 효율을 나타내는 대비 PUE 값이 2.0에서 1.57로 개선되면서 연간 판매 가능한 6,293 MWh의 온열도 생산되었다. 다음으로 적절한 시스템 설치 용량을 가이드하기 위해 데이터 센터 에너지 절감 및 PUE에 영향을 미치는 요인으로 연료전지 운전 온도와 운전 전류밀도를 선정하고 이들의 변화에 따른 분석 결과를 살펴보았다. 연료전지의 운전 온도와 전류밀도 증가에 따라 데이터 센터의 냉방에 소비되는 전력량이 절감되고 PUE는 최소 1.55까지 감소되었다. 하지만 시스템 설치 수가 특정 값에 도달하면서 전기 소비량과 PUE의 개선 효과가 줄어드는 것을 확인하였다. 이와 같은 분석 결과를 기반으로 데이터 센터 연간 에너지 부하를 대응하는 CCHP 시스템 운전 최적화를 수행하면 최대로 전력량을 절감할 수 있고 PUE 값이 최소가 되는데 필요한 시스템의 적정 설치 수를 도출할 수 있으며 시간당 최적의 운전 조건을 제시할 수 있을 것으로 기대된다. 또한 본 연구에서는 CCHP 시스템의 에너지 절감 효과 분석을 토대로 시스템 초기 투자에 대해 간단하게는 논의하였지만 경제적 타당성에 대한 전반적인 분석은 이루어지지 않았다. 향후 연구에서 시스템이 경제적으로 실행 가능성이 있는지에 대한 결정을 내리는 데 도움이 될 수 있도록 최적 운전 조건과 함께 구체적인 경제성 분석을 진행할 예정이다.

Acknowledgments

본 연구는 한국에너지기술연구원의 주요 사업(C3-2425)을 재원으로 수행한 연구 과제의 결과입니다.

References

-

H. Oh, Y. Y. Choi, and Y. J. Sohn, "A study on the fuel cell equivalent circuit modeling", Journal of Hydrogen and New Energy, Vol. 33, No. 3, 2022, pp. 226-231.

[https://doi.org/10.7316/KHNES.2022.33.3.226]

-

L. Belkhir and A. Elmeligi, "Assessing ICT global emissions footprint: trends to 2040 & recommendations", Journal of Cleaner Production, Vol. 177, 2018, pp. 448-463.

[https://doi.org/10.1016/j.jclepro.2017.12.239]

-

H. Rong, H. Zhang, S. Xiao, C. Li, and C. Hu, "Optimizing energy consumption for data centers", Renewable and Sustainable Energy Reviews, Vol. 58, 2016, pp. 674-691.

[https://doi.org/10.1016/j.rser.2015.12.283]

-

P. Sharma and B. Dash, "The digital carbon footprint: threat to an environmentally sustainable future", International Journal of Computer Science & Information Technology, Vol. 14, No. 3, 2022, pp. 19-29.

[https://doi.org/10.5121/ijcsit.2022.14302]

-

J. Cho, J. Yang, C. Lee, and J. Lee, "Development of an energy evaluation and design tool for dedicated cooling systems of data centers: sensing data center cooling energy efficiency", Energy and Buildings, Vol. 96, 2015, pp. 357-372.

[https://doi.org/10.1016/j.enbuild.2015.03.040]

-

H. Zhang, S. Shao, H. Xu, H. Zou, and C. Tian, "Free cooling of data centers: a review", Renewable and Sustainable Energy Reviews, Vol. 35, 2014, pp. 171-182.

[https://doi.org/10.1016/j.rser.2014.04.017]

-

J. Wang, Q. Zhang, S. Yoon, and Y. Yu, "Reliability and availability analysis of a hybrid cooling system with water-side economizer in data center", Building and Environment, Vol. 148, 2019, pp. 405-416.

[https://doi.org/10.1016/j.buildenv.2018.11.021]

-

M. Deymi-Dashtebayaz, S. V. Namanlo, and A. Arabkoohsar, "Simultaneous use of air-side and water-side economizers with the air source heat pump in a data center for cooling and heating production", Applied Thermal Engineering, Vol. 161, 2019, pp. 114133.

[https://doi.org/10.1016/j.applthermaleng.2019.114133]

-

J. I. Yoon, C. H. Son, J. H. Heo, and Y. M. Kim, "Analysis on the energy saving effect of free cooling system in data center", Journal of Power System Engineering, Vol. 18, No. 3, 2014, pp. 73-78.

[https://doi.org/10.9726/kspse.2014.18.3.073]

-

R. E. Rosli, A. B. Sulong, W. R. W. Daud, M. A. Zulkifley, T. Husaini, M. I. Rosli, E. H. Majlan, and M. A. Haque, "A review of high-temperature proton exchange membrane fuel cell (HT-PEMFC) system", International Journal of Hydrogen Energy, Vol. 42, No. 14, 2017, pp. 9293-9314.

[https://doi.org/10.1016/j.ijhydene.2016.06.211]

-

S. Authayanun and V. Hacker, "Energy and exergy analyses of a stand-alone HT-PEMFC based trigeneration system for residential applications", Energy Conversion and Management, Vol. 160, 2018, pp. 230-242.

[https://doi.org/10.1016/j.enconman.2018.01.022]

-

J. H Kim, M. Kim, and J. Kim, "Flow field design and stack performance evaluation of the thin plate separator for high temperature polymer electrolyte membrane fuel cell", Journal of Hydrogen and New Energy, Vol. 29, No. 5, 2018, pp. 442-449.

[https://doi.org/10.7316/KHNES.2018.29.5.442]

-

S. Ham, D. Park, W. Y. Lee and M. Kim, "Simulation to analyze operation strategy of combined cooling and power system using a high-temperature polymer electrolyte fuel cell for data centers", International Journal of Hydrogen Energy, Vol. 48, No. 22, 2023, pp. 8247-8259.

[https://doi.org/10.1016/j.ijhydene.2022.11.257]

- Silicon Valley Leadership Group, "Data center energy forecast: final report", Accenture, 2008. Retrieved from http://dcxdc-ru.1gb.ru/files/27af78d0-f2fd-433b-8d1a-044ada89aa8a.pdf, .

-

G. L. Guizzi and M. Manno, "Fuel cell-based cogeneration system covering data centers’ energy needs", Energy, Vol. 41, No. 1, 2012, pp. 56-64.

[https://doi.org/10.1016/j.energy.2011.07.030]

-

N. Horner and I. Azevedo, "Power usage effectiveness in data centers: overloaded and underachieving", The Electricity Journal, Vol. 29, No. 4, 2016, pp. 61-69.

[https://doi.org/10.1016/j.tej.2016.04.011]

-

Y. J. Kim, J. W. Ha, K. S. Park, K. H. Lee, and Y. H. Song, “ Energy evaluation of data center with low cooling water temperature and free cooling”, Journal of Korean Institute of Architectural Sustainable Environment and Building Systems, Vol. 14, No. 5, 2020, pp. 427-438.

[https://doi.org/10.22696/jkiaebs.20200036]